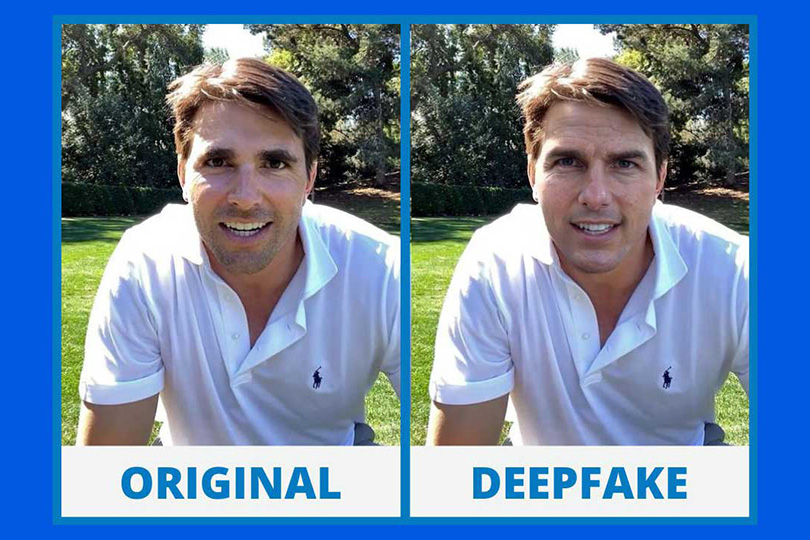

يصف مصطلح التزييف العميق عملية جمع ملفات الصوت والفيديو بواسطة الذكاء الاصطناعي أو التعلم الآلي بشكل دقيق، وتكون كافة مجالات "التزييف العميق" ممكنة بداية من تبديل الوجوه بمعنى استبدال وجه شخص بآخر أو تزامن تحريك الشفاه إذ يمكن ضبط فم المتحدث على ملف صوتي مختلف...

يصف مصطلح "التزييف العميق" عملية جمع ملفات الصوت والفيديو بواسطة الذكاء الاصطناعي أو التعلم الآلي بشكل دقيق، وتكون كافة مجالات "التزييف العميق" ممكنة بداية من تبديل الوجوه بمعنى استبدال وجه شخص بآخر أو تزامن تحريك الشفاه إذ يمكن ضبط فم المتحدث على ملف صوتي مختلف عن الصوت الأصلي أو استنساخ الصوت، حيث يتم استنساخ نسخة من الصوت من أجل استخدامها لقول أشياء أخرى.

ولا يتوقف الأمر عند هذا المستوى، بل يمكن أيضا إنشاء وجوه وأجساد اصطناعية بالكامل على سبيل المثال صورة رمزية رقمية (أفاتار)، بل أن العجيب أنه يمكن استخدام تقنية "التزييف العميق" لاستحضار الموتى مثلما فعل متحف دالي في فلوريدا مع الفنان سلفادور دالي إذ استعان المتحف الأمريكي بهذه التقنية للسماح لزواره بالتقاط صورة حية مع دالي – الذي توفي عام 1989 - حيث يقوم بالتقاط صور سيلفي بنفسه.

تعتمد عملية استخدام الذكاء الاصطناعي للتلاعب بمقطع مصور على تقنية تُعرف بـ"شبكة الخصومة التوليدية" التي تعد نموذجا للتعلم الآلي، حيث تتنافس شبكتين عصبيتين ضد بعضهما من أجل الخروج بنتائج أكثر دقة، إذ ترمي هذه التقنية إلي تحسين النتائج.

وقد نجد صعوبة في فهم المقصود بتنافس شبكتين، لكن سنوضح كيف تجري العملية كالتالي: سوف يبلغ أحد أجهزة الكمبيوتر، الكمبيوتر الآخر إذا كان الاستنساخ الرقمي، سواء أكان مرئيا أو سمعيا، الذي صنعه لأي شخص مقنعا ومطابقا بدرجة كبيرة وكافية مع النسخة الأصلية لهذا الشخص؛ بمعني هل تحريك الشفاه في النسخة المستنسخة مطابقا للنسخة الأصلية، وكذلك هل تعبيرات الوجه متطابقة.

باستخدام "شبكة الخصومة التوليدية" يُجرى تحسين النظام ككل حتى الوصول إلى نتيجة مقنعة، على الرغم من أن هذه التكنولوجيا يطرأ عليها التطوير والتحسين بشكل مستمر، إلا أنه يمكن لأي شخص اكتشاف التلاعب سواء مرئيا أو صوتيا بمعنى آخر الإمساك بـ "التزييف العميق" إذا تم تحديد الشيء الذي نبحث عنه.

طرق اكتشاف "التزييف العميق، ولا يحتاج الإمساك بالمقاطع التي تعرضت لتقنية "التزييف العميق" أن يكون المرء خبيرا في هذه التقنية المعقدة من أجل التمييز بين ما هو حقيقي وبين ما هو مزيف.

وفي ذلك، نقدم بعض النصائح للمساعدة في التحري عن "التزييف العميق"، في البداية شاهد المقطع بتركيز ولا تتسرع في نشره، وأطرح على نفسك سؤالا مفاده: هل هذا المقطع حقيقي؟ ألا يمكن أن يكون مفبركا؟ إذ كنت في حال شك لا تنشره أو ترسله لأي شخص.

وفي حالة وجود شك، يتعين عليك القيام بالبحث عن نفس القصة أو المقطع من مصادر مختلفة لكنها جديرة بالثقة على شبكة الإنترنت، إذ سيساعد العثور على قصة مماثلة على الإمساك بطرف الخيط للوصول إلى القصة الحقيقية.

وفي حالة الشك في مقتطف صوتي أو صورة أو مقطع مصور، قم بإدخال هذا الجزء في محرك البحث غوغل أو محرك بحث DuckDuckGo ثم أبحث عن نسخة أخرى مشابهة. بعد ذلك يمكن المقارنة بين النسختين.

ويمثل رصد واكتشاف بعض الآثار عن وجود تلاعب أكبر تحدي، لكن هناك بعض الجوانب قد تساعد في الأمر مثل وجود لقطات غير متسقة أو تغير في نبرة الصوت أو جودته وغيرها مهما كانت صغيرة، فقد تكون مفيدة وعليك أن ثق في حواسك البصرية والسمعية وأسال نفسك دائما: هل يبدو الأمر منطقيا؟

ويجب أن تتذكر أن الأمر يتطلب فقط الكثير من التركيز وربما قد يتطلب الأمر طلب المساعدة من شخص آخر ليساعدك في تحديد أماكن التلاعب التي قد تكون أشياء بسيطة مثل الأنف أو الأذن أو الأسنان ودرجة بياضها أو حتى تسريحة الشعر وهل يبدو الأمر متطابقا.

قد يتطلب الأمر مشاهدة المقطع بمعدل مشهد لاكتشاف التناقضات، فيما يمكن الاستعانة على سبيل المثال بـ "مُشغل الوسائط في. أل. سي" أو موقع watchframebyframe.com.

كذلك قم بتكبير حركات الفم والشفاه وقارنها بالنسخة الأصلية لاكتشاف تزامن تحريك الشفاه، وهل يبدو الأمر منطقيا، قم بتعزيز المهارات السمعية والمرئية، يتضح من كل ما ذُكر أن الأمر يتعلق برمته بحواس الإنسان خاصة المهارات السمعية والمرئية، ولحسن الحظ يمكن تعزيز قدراتك هذه، فمن خلال هذا التدريب يمكنك تحسين مهارات السمع والرؤية لاكتشاف أي تلاعب في الصورة أو الصوت.

أما فيما يتعلق بالمجتمعات بشكل عام، فإن مخاطر تقنية "التزييف العميق" تعتمد على طريقة استهلاكنا للإنترنت إذ يشاهد الشخص الكثير عند تصفح الشبكة العنكبوتية ومواقع التواصل الاجتماعي ولا يكون على الدوام متأكدا بما ينشره أو يشاركه وهل هو حقيقي أم مفبرك؟ أما في المجتمعات التي تعاني من حالة استقطاب، فإن تقنية "التزييف العميق" تعد فرصة كبيرة لخداع الأشخاص كي يصدقوا أشياء بعينها.

واللافت أن الأمر لا يتعلق بجودة المقطع المزيف فقد يكون محل الأمر ما رأيته حتى لو لم يكن صحيحا على سبيل المثال مقطع مصور لنجم المنتخب الإنجليزي السابق ديفيد بيكهام وهو يتحدث بتسع لغات.

يشار إلى أنه في أبريل / نيسان عام 2019، أطلق بيكهام حملة للقضاء على الملاريا عن طريق توجيه رسالة عبر مقطع مصور بتسع لغات. بدأ الرسالة باللغة الإنجليزية ثم تحدث بثماني لغات أخرى، بيد أن اللغات الثمانية الأخرى لم تكن بصوته وإنما بأصوات ناجين من الملاريا وأطباء، وفي ذلك الوقت، قالت المنظمة البريطانية التي أنتجت المقطع إنها استخدمت تقنية خاصة بالفيديو حتى يبدو بيكام وكأنه يتحدث بهذه اللغات الثمانية.

وسياسيا، تم إنتاج فيديو مزيف بتقنية "التزييف العميق" انتشرت بشكل كبير عن طريق موقع De Correspondent الإخباري يُظهر فيه رئيس وزراء هولندا مارك روته يتحدث عن تغيير كبير في سياسته، يما يفيد أنه سيدعم بشكل كامل التدابير المناخية بعيدة المدى.

وقد يستفيد بعض السياسيين من مناخ إعلامي ملي بالمعلومات الخاطئة، إلا أن وجود تقنية مثل "التزييف العميق" تسمح لهم بالزعم بأن ما قالوه غير حقيقي ومزيف وسيكون من الصعب إثبات العكس، وربما يكون المثال الأوقع على هذا الأمر، ادعاء الرئيس الأمريكي السابق دونالد ترامب عام 2016 أن تسجيلا مصورا يعود لعام 2005 يتحدث فيه بطريقة بذيئة عن النساء، كان مفبركا رغم أنه قدم اعتذارا عن تلك العبارات فيما بعد.

خلاصة القول إن نشر معلومات مضللة يمكن أن يكون لأسباب أبرزها إثارة الشكوك والجدل أو دعم بعض المعتقدات بطريقة مخادعة، لكنها تحدث الضجيج المطلوب، وقد يصعب على المرء التحقق من المقاطع المصورة أو الصوتية التي تم التلاعب بها، لكن يمكن أن يتدرب المرء على معرفة كيف يمكنه اكتشاف مواضع "التزييف العميق"، وقبل كل شيء، يتعين التوقف عن نشر أو مشاركة أي شيء لم يتم التحقق من مصداقيته وصحته.

أضرار التقنية وفوائدها

يرى الخبراء، حسب صحيفة "الغارديان" البريطانيّة، أن تقنيّة التزييف العميق تتسبّب بالضيق والإحراج والاستفزاز والتخويف للآخرين، وذلك عندما توظّف في السخرية التي قد تبدو مهينة في بعض الأحيان. كما يسأل البعض، الآتي: هل ستتسبب هذه التقنية في وقوع حوادث دولية كبيرة؟ وفي سياق ذلك، أعرب المتخصّصون عن قلقهم لانعدام ثقة الجماهير بعد انتشار هذه التقنية، والتي قد تعرفها شبكات التواصل الاجتماعي، ليُصبح من السهل إثارة الشكوك حول أحداث معيّنة.

بالمقابل، يرى بعض المتخصّصين الآخرين أن استخدامات تقنية التزييف العميق قد تتركّز على جوانب أخرى كتلك الترفيهيّة والتعليميّة، إذ من الممكن تسخير هذه التكنولوجيا في المعارض والمتاحف، من خلال عرض صورة مزيفة لأحد المشاهير حتى يستطيع الأشخاص التقاط صور ذاتية لهم معه، بخاصة مع أولئك الفنانين والمشاهير الذين رحلوا عن دنيانا. كما قد تستخدم التقنية في تحسين دبلجة الأفلام الأجنبيّة.

وثمّة أمر آخر يثير الجدل حول التقنية، هو جعل الممثّلين الراحلين يلعبون أدوار البطولة في بعض الأعمال! وفي هذا السياق، وتحديدًا في نهاية عام 2020 لجأ مسلسل "بلو بل لا في" الفرنسي إلى استخدام هذه التقنية من أجل تعويض غياب إحدى الممثلات بسبب مخالطتها بشخص مصاب بفيروس كورونا، من دون أن يتنبه المشاهدون إلى ذلك، حتى أولئك الأكثر شغفًا منهم بالمسلسل.

كيف تنفّذ تقنية التزييف العميق؟

Zao، التطبيق الصيني الذي لاقى انتشارًا واسعًا، وهو يدعم تقنية التزييف العميق من الصعب تنفيذ التقنيّة المعقّدة المذكورة على جهاز كُمبيوتر عادي، بل هي تتطلّب جهاز كمبيوتر سطح المكتب ذا المعالج الرسومي القوي حتى يقلّ وقت معالجة الصور والفيديوهات، من أيّام وأسابيع إلى ساعات. أضف إلى ذلك، هناك الكثير من الأدوات المتاحة للتزييف العميق؛ في هذا الإطار، تصدر شركات عدة برامج وتطبيقات تدعم هذه التقنية، منها: Zao التطبيق الصيني الذي لاقى انتشارًا واسعًا. علمًا أنّه يسهل اكتشاف التزييف العميق ذي الجودة الرديئة، إذ قد يكون تزامن الشفاه سيئًا أو لون الجلد غير متناسق، وهناك وميض حول حواف الوجه، أو تجاهل لبعض التفاصيل، مثل: لون وشكل الأسنان أو المجوهرات، أو تأثيرات الإضاءة الغريبة، مثل: الإضاءة غير المتسقة والانعكاسات على القزحية. إشارة إلى أنّه يكثر المحترفون في المجال؛ في هذا السياق، اكتشف باحثون أميركيون في عام 2018م. أن الوجوه في التزييف العميق لا تومض بشكل طبيعي، وبدا الأمر ثغرة في التقنية ليسهل الكشف عنها، إلّا أن أعمالًا لاحقة ظهرت متجاوزة ذلك أي جعلت وميض العين واضحًا في الوجوه بعد ذلك. لذا، يسعى العديد من الحكومات والجامعات وشركات التكنولوجيا والأبحاث إلى محاولة التقصي عن الـdeepfake لإدراك أبعاده.

مستقبل صناعة المحتوى

يُطلق على مقاطع الفيديو المعدّلة التي يتم إنشاؤها بواسطة الذكاء الاصطناعي "التزييف العميق" أو "التلاعب المعمق". بالرغم من سمعته السيئة في مجال التزييف، خصوصاً لجهة كونه جزءاً من الأخبار الكاذبة التي يصعب تقفي أثرها والتحقق منها، يتزايد استخدامه بسرعة في قطاعات تشمل الأخبار والترفيه والتعليم، على اعتبار أنّ تكاليف إنتاجه أقلّ. فما هي تلك الاستخدامات؟ وهل يكون التزييف المعمق مستقبل صناعة المحتوى؟

كانت شركة "سينثيجا" Synthesia ومقرها لندن التي تنشئ مقاطع فيديو تدريبية للشركات مدعومة بالذكاء الاصطناعي، إحدى أوائل المتبنين التجاريين للتقنية. فإنشاء مقطع فيديو بواسطة الذكاء الاصطناعي، باستخدام نظام Synthesia، يمكن أن يتم ببساطة بالاختيار من بين عدد من الصور الرمزية، وكتابة النص. تنقل "بي بي سي" عن الرئيس التنفيذي والمؤسس المشارك للشركة، فيكتور ريباربيلي، قوله إن "هذا هو مستقبل إنشاء المحتوى". ويقول ريباربيلي إن هذا يعني أن الشركات العالمية يمكنها بسهولة إنشاء مقاطع فيديو بلغات مختلفة، مثل الدورات التدريبية الداخلية. ويشرح: "لنفترض أن لديك 3000 عامل في أميركا الشمالية، بعضهم يتحدث الإنكليزية، لكن البعض الآخر قد يكون أكثر دراية بالإسبانية. إذا كان عليك توصيل معلومات معقدة إليهم، فإن ملف PDF المكون من أربع صفحات ليس طريقة رائعة. سيكون من الأفضل كثيراً إنشاء مقطع فيديو مدته دقيقتان أو ثلاث دقائق باللغتين الإنكليزية والإسبانية". ويتابع: "تسجيل كل مقطع من مقاطع الفيديو هذه هو عمل كثير. الآن يمكننا القيام بذلك مقابل تكاليف إنتاج قليلة".

ليس الموضوع حكراً على "سينثيجا"، بل هناك العديد من الشركات التي تخوض هذا المجال. ZeroFox هي شركة أميركية للأمن السيبراني تتعقب التزييف العميق. ويقول كبير مسؤولي التكنولوجيا فيها، مايك برايس، إن استخدامها التجاري "ينمو بشكل ملحوظ عاماً بعد عام، ولكن من الصعب تحديد الأرقام الدقيقة". ويقول الرئيس التنفيذي لشركة Veritone الأميركية لتكنولوجيا الذكاء الاصطناعي، تشاد ستيلبرغ، إن القلق المتزايد بشأن التزييف العميق الخبيث يعيق الاستثمار في الاستخدام التجاري المشروع للتكنولوجيا. ويوضح أن "مصطلح التزييف العميق كان له بالتأكيد استجابة سلبية من حيث الاستثمار الرأسمالي في هذا القطاع"،"يمكن لوسائل الإعلام والمستهلكين، عن حق، أن يروا بوضوح المخاطر المرتبطة به".

من جانبه، يقول مايك باباس، الرئيس التنفيذي لشركة Modulate، وهي شركة ذكاء اصطناعي تتيح للمستخدمين إنشاء صوت لشخصية أو شخص مختلف، إن الشركات في قطاع الإعلام التركيبي التجاري الأوسع "تهتم حقاً بالأخلاق" وإن المستثمرين "يسألون عن السياسات الأخلاقية". وتعتبر أستاذة القانون والابتكار والمجتمع بكلية الحقوق في نيوكاسل وخبيرة التزييف العميق، ليليان إدواردز، أن إحدى المشكلات التي تحيط بالاستخدام التجاري لهذه التكنولوجيا هي من يمتلك حقوق مقاطع الفيديو. وتشرح أنه "على سبيل المثال، إذا تم استخدام شخص ميت مثل مغني الراب توباك، فهناك نقاش مستمر حول ما إذا كان يجب على أسرته امتلاك الحقوق [والحصول على دخل منها]. هذا يختلف حالياً من بلد إلى آخر".

"فيسبوك" يستخدم الذكاء الاصطناعي لكشف التزييف العميق

قدم باحثان في "فيسبوك" طريقة تعتمد على الذكاء الاصطناعي من شأنها كشف عمليات "التزييف العميق" (ديب فايك)، وهي صور ومقاطع فيديو مزورة بحرفية عالية تجعلها واقعية للغاية، بهدف المساعدة في تحديد مصدرها.

وتطرح عمليات التزييف هذه مشكلة على المواقع الإلكترونية، إذ إنها قد تستخدم للتلاعب بمستخدمي الإنترنت أو تشويه سمعة الأشخاص من خلال تركيب مقاطع تُظهرهم يقولون أو يفعلون أموراً لم يقولوها أو يفعلوها حقاً. وتعتمد عمليات التوليف هذه على تقنيات الذكاء الاصطناعي.

وقال الباحثان لدى "فيسبوك"، تال هاسنر وشي يين، اللذان عملا على الموضوع مع جامعة ولاية ميشيغان، إن "نظامنا سيسهل كشف الـ’ديب فايك‘ وتعقب المعلومات المرتبطة بها"، وتقدم الطريقة التي أعلن عنها الباحثان "أدوات لتسهيل التحقيق في شأن الأحداث المرتبطة بعمليات تضليل إعلامي منسقة تستعين بالتزييف العميق".

ولتطوير هذا النظام، استخدم الباحثان تقنية تسمى "الهندسة العكسية" تقوم على تفكيك طريقة صنع منتج ما، وفي هذه الحالة مقطع فيديو أو صورة، وترصد البرمجية التي يستعين بها النظام أي ثغرات على عملية التوليف (المونتاج) تؤثر على البصمة الرقمية للصور، وفي مجال التصوير الفوتوغرافي، تتيح هذه البصمة التعرف إلى الكاميرا المستخدمة. وفي المعلوماتية، يمكن لهذه التقنية "التعرف إلى النظام المستخدم في صنع عمليات التزييف"، وفق الباحثَين، وقدمت شركة "مايكروسوفت" العام الماضي برمجية من شأنها المساعدة في رصد عمليات الـ"ديب فايك" في الصور أو الفيديوهات، وهي من البرامج الكثيرة المصممة للتصدي للتضليل الإعلامي قبل الانتخابات الرئاسية الأميركية.

وفي عام 2019، عممت "غوغل" آلاف مقاطع الفيديو المزورة على يد أفراد من طواقم عملها بأسلوب "ديب فايك"، بهدف وضعها في تصرف الباحثين الراغبين في تطوير أساليب لكشف الصور التي خضعت للتلاعب.

قدّم موقع علم الأنساب، "ماي هريتج"، أداة تستخدم تقنية التزييف العميق، لتحريك الوجوه في صور الأقارب المتوفين، وأقرّت الشركة أن بعض الأشخاص قد يجدون الميزة، المسماة "ديب نوستالجيا"، "مفزعة"، بينما قد يعتبرها آخرون "سحرية"، وقالت إن الميزة لم تتضمن إضافة الكلام، لتجنب خلق "أشخاص مزيفين".

يأتي ذلك في الوقت الذي تدرس فيه الحكومة في بريطانيا تشريعات بشأن تقنية التزييف العميق، وتدرس اللجنة القانونية مقترحات لجعل إنشاء مقاطع فيديو مزيفة دون موافقة أمرا غير قانوني، وقالت "ماي هريتج" إنها تعمّدت عدم تضمين الكلام في الميزة "من أجل منع إساءة استخدام التطبيق، مثل إنشاء مقاطع فيديو مزيفة لأشخاص أحياء".

وكتبت في خانة الأسئلة الشائعة حول التكنولوجيا الجديدة "هذه الميزة مخصصة للنوستالجيا، أي لإعادة الأسلاف المحبوبين إلى الحياة"، لكنها أقرّت أيضا بأن "بعض الناس يحبون ميزة ديب نوستالجيا ويعتبرونها سحرية، بينما يجدها آخرون مفزعة ولا يحبونها".

وتم تطوير التكنولوجيا الكامنة وراء "ديب نوستالجيا" بواسطة شركة "دي- آي دي" الإسرائيلية، واستخدمت الذكاء الاصطناعي ودربت خوارزمياتها على مقاطع فيديو مسجلة مسبقا لأشخاص أحياء يحركون وجوههم ويومئون.

في موقع "ماي هريتج"، يتم إحياء الشخصيات التاريخية مثل الملكة فيكتوريا وفلورنس نايتنغال. وفي وقت سابق من هذا الشهر، احتفالا بعيد ميلاده، وضعت الشركة مقطع فيديو لأبراهام لنكولن على يوتيوب باستخدام هذه التكنولوجيا.

ويظهر الرئيس الأمريكي السابق بالألوان، وهو يتحدث، وبدأ الناس في نشر مقاطع فيديو أسلافهم المعاد إحيائهم على تويتر، مع ردود متباينة. ووصف البعض النتائج بأنها "مذهلة" و"عاطفية" بينما أعرب آخرون عن قلقهم.

في ديسمبر/كانون أول، أنشأت القناة الرابعة البريطانية ملكة مزيفة قامت بتوجيه رسالة بمناسبة عيد الميلاد، كجزء من تحذير حول كيفية استخدام التكنولوجيا لنشر أخبار مزيفة.

اضف تعليق